Définition Deep Learning 6 minutes

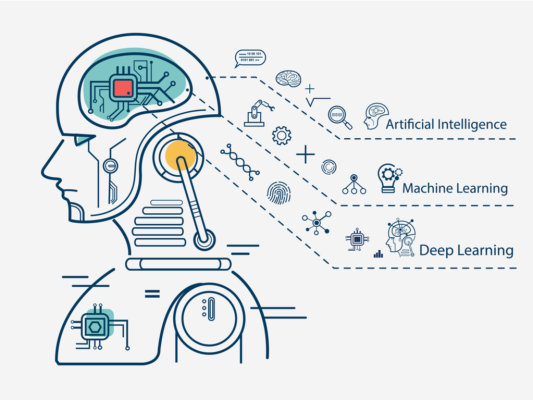

Le Deep Learning est un type d’apprentissage automatique (ML) et d’intelligence artificielle (AI) qui imite la capacité du cerveau humain à acquérir certains types de connaissances. Le Deep Learning est un aspect important de la science des données qui comprend les statistiques et la modélisation prédictive. Il est extrêmement utile aux data scientists chargés de collecter, d’analyser et d’interpréter d’énormes quantités de données. L’apprentissage profond rend ce processus plus facile et plus rapide.

Dans son sens le plus simple, le Deep Learning peut être considéré comme une méthode permettant d’améliorer l’analyse prédictive. Bien que les algorithmes traditionnels d’apprentissage automatique soient linéaires, les algorithmes de Deep Learning sont placés dans une structure hiérarchique qui augmente le niveau d’abstraction et de complexité.

Pour comprendre le Deep Learning, imaginez un enfant dont le premier mot est « chien ». L’enfant apprend ce qu’est un chien et ce qu’il n’est pas en pointant des objets du doigt puis en prononçant le mot « chien ». Le parent répondra « Oui, c’est un chien » ou « Non, ce n’est pas un animal ». Au fur et à mesure qu’il continue à montrer des objets, l’enfant est plus conscient des caractéristiques que tous les chiens partagent. Ce que l’enfant fait, sans le savoir, contribue à clarifier une abstraction complexe – la notion de chien créant une hiérarchie dans laquelle chaque niveau d’abstraction est construit à l’aide des connaissances acquises au niveau précédent.

Qu’est-ce que c’est ? Le Deep Learning fonctionne

Les programmes informatiques qui font appel à l’apprentissage profond suivent le même processus que celui suivi par un jeune enfant lorsqu’il apprend à reconnaître un chien. Chaque algorithme de la hiérarchie applique une transformation non linéaire à son entrée et utilise les informations qu’il a apprises pour construire un modèle de sortie statistique. Le processus se poursuit jusqu’à ce que la sortie atteigne le niveau de précision acceptable. Le nombre de couches que les données doivent traverser est à l’origine du terme « profond ».

Dans l’apprentissage automatique traditionnel, le processus d’apprentissage est contrôlé par le programmeur, qui doit être très précis lorsqu’il décrit à l’ordinateur les éléments qu’il doit rechercher pour déterminer si une image est liée à un chien ou non. Il s’agit d’un long processus appelé extraction de caractéristiques, et les performances de l’ordinateur dépendent entièrement de la capacité du programmeur à définir précisément les caractéristiques du « chien ». L’avantage de l’apprentissage profond est que le programme développe l’ensemble des caractéristiques par lui-même, sans supervision. L’apprentissage non supervisé est non seulement plus efficace, mais il est aussi généralement plus précis.

Dans un premier temps, le programme informatique pourrait recevoir des données d’apprentissage, c’est-à-dire un ensemble d’images dans lequel l’humain a identifié chaque image comme étant « chien » ou « pas chien » à l’aide de métabalises. Le programme utilise les informations qu’il obtient des données d’apprentissage pour construire un ensemble de caractéristiques pour « chien » et ensuite construire un modèle prédictif. Dans ce cas, le modèle que l’ordinateur développe en premier lieu prédit que tout objet dans une image ayant quatre pattes ou une queue sera désigné comme « chien ». Naturellement, l’ordinateur ne connaît pas les termes « quatre pattes » ou « queue ». Il cherche simplement des modèles dans les données. À chaque répétition, le modèle prédictif devient plus complexe et plus précis.

Contrairement à un enfant qui peut avoir besoin de semaines, voire de mois, pour comprendre la signification du mot « chien », un programme informatique qui utilise des algorithmes d’apprentissage profond peut montrer un ensemble de matériel d’apprentissage et filtrer des millions d’images, identifiant précisément les images de chiens en quelques minutes.

Pour atteindre un niveau de précision raisonnable, les programmes d’apprentissage profond doivent avoir accès à des quantités massives de données d’apprentissage ainsi qu’à une puissance de traitement, ce qui n’était pas facilement accessible aux programmeurs avant l’ère de l’informatique en nuage et des données volumineuses. Comme les logiciels d’apprentissage profond peuvent construire des modèles statistiques complexes à partir de leurs propres données itératives, ils sont en mesure de créer des modèles prédictifs précis à partir de quantités massives de données non étiquetées et non structurées. Cet aspect est crucial car l’Internet des objets (IoT) continue de gagner en popularité et une grande partie des données générées par les humains et les machines sont non étiquetées et non structurées.

Que sont les réseaux neuronaux à apprentissage profond ?

Un type d’algorithme d’apprentissage automatique désigné sous le nom de réseaux neuronaux artificiels constitue la base de la majorité des modèles d’apprentissage profond. C’est pourquoi l’apprentissage profond est parfois appelé réseaux neuronaux profonds ou apprentissage neuronal profond.

Les réseaux neuronaux existent sous différentes formes, telles que les réseaux neuronaux convolutifs, les réseaux neuronaux artificiels et les réseaux neuronaux à action directe, et chacun d’entre eux présente ses propres avantages dans des situations particulières. Cependant, ils fonctionnent tous de manière similaire en fournissant des données, puis en laissant le modèle décider lui-même s’il est parvenu à la bonne interprétation ou décision concernant une partie particulière des données.

Les réseaux neuronaux requièrent un processus d’essais et d’erreurs, ce qui explique pourquoi ils ont besoin d’une énorme quantité de données pour pouvoir se développer. Ce n’est pas un hasard si les réseaux neuronaux n’ont gagné en popularité qu’après que la majorité des entreprises eurent adopté l’analyse de données à grande échelle et accumulé d’énormes volumes de données. Étant donné que les premières instances du modèle nécessitent des suppositions quelque peu éclairées sur le contenu des images ou d’une partie du discours, les données utilisées dans la phase de formation doivent être identifiées pour permettre au modèle de déterminer si sa prédiction était juste. Cela signifie que, bien que de nombreuses entreprises qui utilisent des quantités massives de données disposent d’une grande quantité de données, les données non structurées ne sont pas aussi utiles. Les données non structurées peuvent être analysées par un modèle d’apprentissage profond après avoir été entraîné à un niveau de précision satisfaisant. Les modèles de Deep Learning ne peuvent pas s’entraîner sur des données non structurées.

Méthodes de Deep Learning

Différentes méthodes peuvent être employées pour construire des modèles de deep learning robustes. Ces méthodes comprennent la réduction du taux d’apprentissage ; l’apprentissage par transfert, l’apprentissage à partir de zéro et l’abandon.

- Réduction du taux d’apprentissage. Le taux d’apprentissage est un hyperparamètre – une mesure qui détermine le système ou définit les exigences de son fonctionnement avant le processus d’apprentissage. Il détermine la quantité de changement que le modèle subit en réponse à l’erreur estimée chaque fois que les poids du modèle sont modifiés. Un taux d’apprentissage élevé peut entraîner des processus d’apprentissage instables ou l’apprentissage d’un ensemble de poids défectueux. Des taux d’apprentissage trop faibles peuvent entraîner un processus d’apprentissage de longue durée, plus susceptible de ralentir.

- La méthode de diminution du taux d’apprentissage, également appelée recuit du taux d’apprentissage , également connue sous le nom de taux d’apprentissage adaptatif, est le processus d’ajustement du taux d’apprentissage pour augmenter les performances et diminuer le temps de formation. Les adaptations les plus simples et les plus populaires du taux d’apprentissage pendant la formation sont des méthodes visant à diminuer le taux d’apprentissage au fil du temps.

- Transfert de connaissances. Cette procédure consiste à affiner un modèle précédemment formé. Elle nécessite une interface avec un réseau déjà établi. La première étape consiste à fournir au réseau existant de nouvelles données qui comprennent des classifications non identifiées auparavant. Une fois que des ajustements ont été apportés au réseau et que de nouvelles tâches ont été ajoutées, elles peuvent être réalisées en utilisant des capacités de catégorisation plus spécifiques. Cette technique a l’avantage de nécessiter moins de données que les autres approches, et de réduire le temps de calcul à quelques minutes, voire quelques heures.

- Formation en partant de zéro. Cette méthode exige du développeur qu’il recueille une énorme collection de données étiquetées, puis qu’il mette en place un réseau capable d’apprendre des caractéristiques et des modèles. Cette technique est particulièrement utile pour les applications récentes et pour les applications comportant un grand nombre de types de résultats. Cependant, ce n’est pas une option populaire car elle nécessite de grandes quantités de données, ce qui peut faire passer le temps de formation de plusieurs jours à plusieurs semaines.

- Abandon. Cette méthode vise à résoudre le problème de l’overfitting des réseaux qui ont beaucoup de paramètres, en supprimant de manière aléatoire les unités ainsi que leurs connexions du réseau neuronal pendant la formation. Il a été prouvé que l’utilisation de la technique du dropout a la capacité d’améliorer l’efficacité des réseaux neuronaux lorsqu’ils contrôlent des tâches d’apprentissage dans des domaines tels que la reconnaissance vocale, la classification de documents ainsi que la biologie computationnelle.

Exemples d’applications d’apprentissage profond

Comme les modèles d’apprentissage profond traitent les données d’une manière similaire à celle du cerveau humain, ils peuvent être utilisés pour diverses tâches effectuées par les humains. L’apprentissage profond est actuellement utilisé dans une variété d’outils de reconnaissance d’images, de reconnaissance vocale naturelle et de logiciels de traitement du langage. Ces outils commencent à être utilisés dans des applications aussi diverses que les voitures et les services de traduction.

À quoi sert exactement l’apprentissage profond ?

Les cas d’utilisation actuels de l’apprentissage profond englobent toutes sortes d’applications d’analyse de données massives, avec un accent particulier sur celles qui se concentrent sur le traitement naturel du langage, les signaux de stock de traduction, la sécurité des diagnostics médicaux des réseaux et la reconnaissance d’images.

Les domaines spécifiques dans lesquels le Deep Learning est actuellement utilisé sont les suivants :

- L’expérience client. Les modèles de Deep Learning sont déjà utilisés pour créer des chatbots. Et, à mesure qu’il se développe, l’apprentissage profond devrait être utilisé dans une variété d’entreprises pour améliorer l’expérience client et la satisfaction des clients.

- Génération de texte. Les machines apprennent la grammaire et le style d’un texte, puis appliquent le modèle pour créer un texte entièrement nouveau, conforme à la grammaire, à l’orthographe et au style du texte original.

- L’aéronautique ainsi que le militaire. Le Deep Learning est utilisé pour détecter des images satellites qui peuvent identifier des zones d’intérêt mais aussi des zones sûres et non impliquées pour les troupes.

- L’automatisation industrielle. Le Deep Learning améliore la sécurité des travailleurs sur les lieux de travail tels que les entrepôts et les usines en fournissant des services qui détectent le moment où une personne ou un objet s’approche d’un automatisme.

- Il est possible d’ajouter des couleurs. Il est possible d’ajouter de la couleur à des images et des vidéos en noir et blanc avec des modèles de Deep Learning. Auparavant, il s’agissait d’un processus manuel laborieux.

- Recherche dans le domaine médical. Les chercheurs en cancérologie ont commencé à mettre en œuvre le Deep Learning dans leur pratique pour détecter automatiquement les cellules cancéreuses.

- Vision par ordinateur. Le Deep Learning a considérablement augmenté les capacités de vision par ordinateur, fournissant aux ordinateurs une précision extrême pour la reconnaissance et la détection, la restauration et la segmentation des images.

Limites et problèmes

L’inconvénient le plus important des algorithmes d’apprentissage profond est qu’ils n’apprennent que par l’observation. Cela signifie qu’ils ne savent pas ce qui est présent dans les données sur lesquelles ils ont appris. Si un utilisateur ne peut accéder qu’à une quantité infime de données, ou si les données proviennent d’une source particulière qui n’est pas nécessairement représentative d’un domaine fonctionnel plus large, les modèles ne pourront pas apprendre de manière générale.

La question du biais est un problème important dans les modèles d’apprentissage profond. Si un modèle est formé à l’aide de données biaisées, il reproduira ces biais dans ses prédictions. Il s’agit d’une question difficile pour les programmeurs d’apprentissage profond, car les modèles apprennent à différencier les variations subtiles des éléments d’information. Les facteurs qu’il considère comme importants ne sont pas clairement expliqués par le programmeur. Cela signifie, par exemple, que les algorithmes de reconnaissance faciale peuvent déterminer la personnalité d’une personne en fonction d’éléments tels que le sexe ou la race, sans que les programmeurs en soient conscients.

Le taux d’apprentissage peut être un problème majeur dans les modèles d’apprentissage profond. Si le taux est excessif, le modèle peut converger trop rapidement, ce qui se traduit par une solution insatisfaisante. Si le taux est faible, le processus pourrait ralentir et il sera plus difficile d’arriver à une réponse.

Les exigences matérielles requises pour exécuter les modèles de Deep Learning peuvent également entraîner des limitations. Des unités de traitement graphique à haute performance (GPU) ainsi que des unités similaires pour le traitement sont nécessaires pour améliorer l’efficacité et réduire le temps de traitement. Cependant, elles sont coûteuses et consomment d’énormes quantités d’énergie. Parmi les autres exigences matérielles figurent la mémoire vive (RAM) et un disque dur ou un lecteur à état solide (SSD).

Parmi les autres défis et limitations, citons :

- Le Deep Learning nécessite de grandes quantités de données. De plus, les modèles les plus précis et les plus puissants auront besoin d’un plus grand nombre de paramètres qui, à leur tour, nécessiteront davantage de données.

- Une fois formés, les modèles d’apprentissage profond sont peu flexibles et ne peuvent pas gérer le multitâche. Ils peuvent offrir des solutions précises et efficaces mais elles sont limitées pour le problème spécifique. En cas de problème similaire, il faudra réentraîner le système.

- Tout ce qui implique un raisonnement comme la programmation ou l’utilisation de la méthode scientifique, la planification à long terme et la manipulation de données à l’aide d’algorithmes est bien au-delà de ce que les techniques de Deep Learning actuellement disponibles peuvent faire, même avec des données énormes.

- Deep Learning et apprentissage automatique

- Le Deep Learning est un sous-ensemble de l’apprentissage automatique qui est différent dans sa façon de résoudre les problèmes. L’apprentissage automatique nécessite un expert du domaine pour reconnaître les caractéristiques les plus couramment utilisées.

Au contraire, le Deep Learning apprend les caractéristiques progressivement. Les algorithmes du Deep Learning nécessitent donc beaucoup plus de temps pour être développés par rapport aux algorithmes d’apprentissage automatique qui ne prennent que quelques minutes à quelques heures. Cependant, c’est l’inverse qui se produit lors des tests. Les algorithmes de Deep Learning prennent moins de temps à évaluer que les algorithmes d’apprentissage automatique, et dont le temps de test augmente avec la taille des données.

De plus, l’apprentissage automatique ne nécessite pas le même équipement haut de gamme et les mêmes GPU haute performance que le Deep Learning.

Au final, de nombreux data scientists préfèrent la méthode traditionnelle de l’apprentissage automatique au Deep Learning en raison de son interprétabilité supérieure ou de sa capacité à comprendre les solutions. Les algorithmes d’apprentissage automatique sont préférables lorsque les données ne sont pas volumineuses.

Les situations dans lesquelles le Deep Learning devient préférable comprennent les situations dans lesquelles il y a une énorme quantité de données ou un manque de compréhension du domaine de l’introspection des caractéristiques ou des questions plus complexes comme la reconnaissance du langage naturel et le traitement de la parole.